优化算法是机器学习的重要组成部分,但是传统的优化算法并不完全适用于机器学习,因为通常来说机器学习模型的参数维度很高或涉及的样本数巨大,这使得一阶优化算法在机器学习中占据主流地位。

为了在应用中推广加速一阶优化算法,中国图象图形学学会与浙江师范大学数理医学院、浙江师范大学数学与计算机科学学院、西安科技大学数学与统计学院共同主办了“CSIG-机器学习中的加速一阶优化算法系列讲座”,由中国图象图形学学会机器视觉专委会承办,主讲专家为中国图象图形学学会机器视觉专委会主任林宙辰教授。本次系列讲座分为六讲,从2022年6月17号起,每周五晚8-9点举行。

在6月17号、24号和7月1号前三次讲座取得巨大成功后。7月8号晚上8点,林宙辰教授在线上做了本次系列讲座的第四讲,关于非凸优化中的加速算法,特别针对颇有挑战性的非凸优化理论和流行的一阶非凸加速优化算法进行了详细深入的讲解。本次讲座十分受关注,讲座直播由腾讯会议和第三方蔻享直播同时进行。

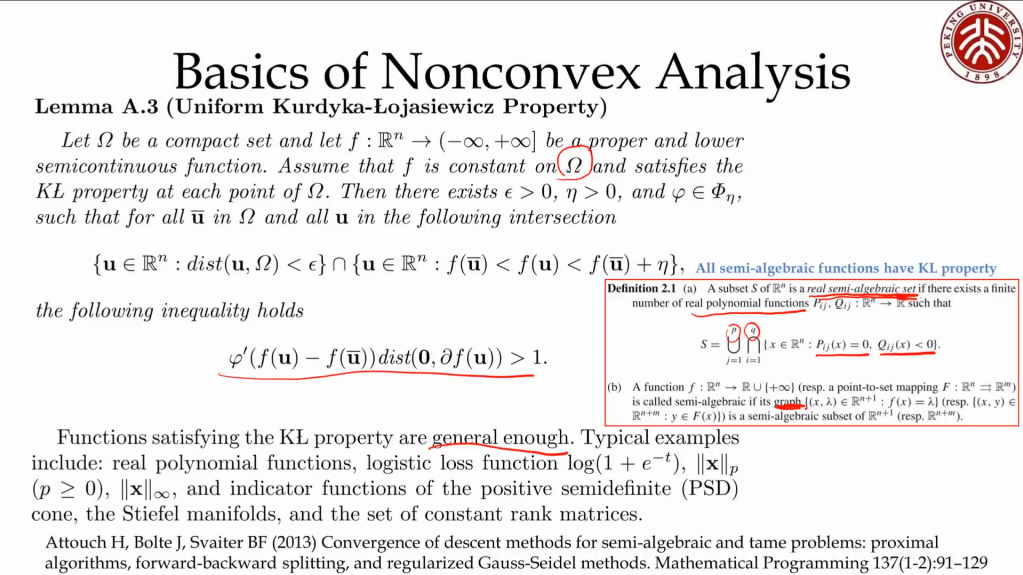

林宙辰教授首先详细介绍了非凸优化分析中的基本概念和理论,并对近年非凸优化理论研究中常用的Kurdyka-Lojasiewicz(KL)条件进行了深入浅出的讲解,利用小波分析和物理学中的测不准原理做了很形象的类比,同时列举了一些常见的满足KL条件的函数的例子。

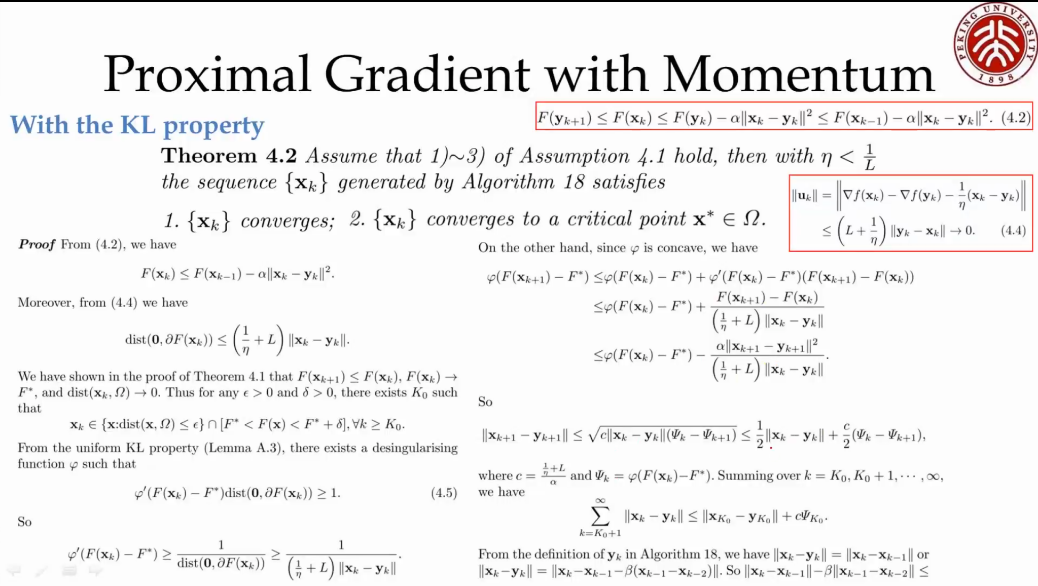

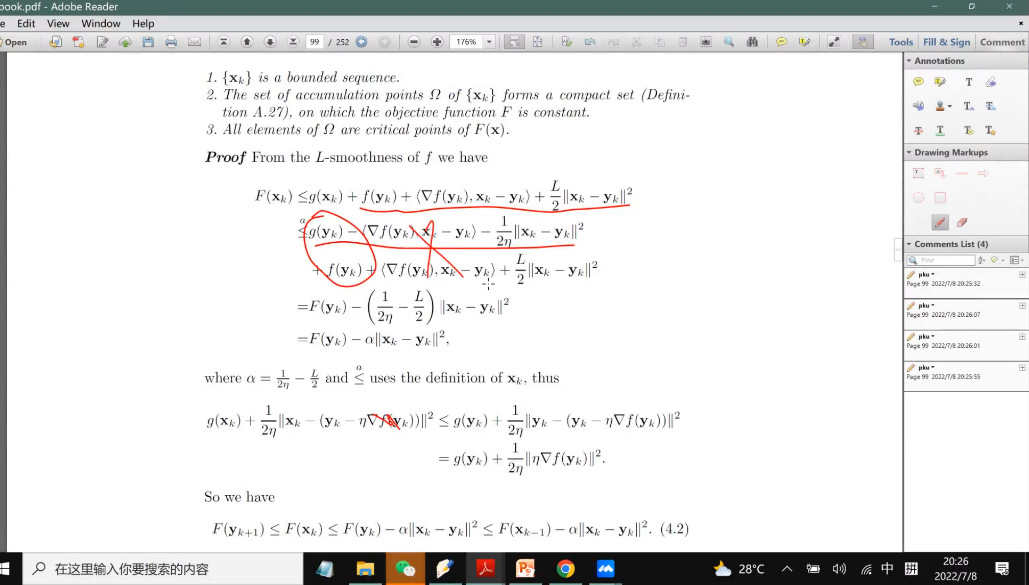

然后林宙辰教授开始介绍非凸函数的一阶邻近梯度法的动量加速算法以及相关收敛性质,并对收敛性证明中的关键性步骤进行了详细的推导和演示。

林宙辰教授进一步针对非凸优化目标函数的不同情况,分析了带动量项的非凸优化一阶邻近梯度加速算法的收敛率。

接着林宙辰教授又分析讲解了单调的带动量项的非凸优化一阶邻近梯度加速算法,并对相关收敛性证明进行了介绍。

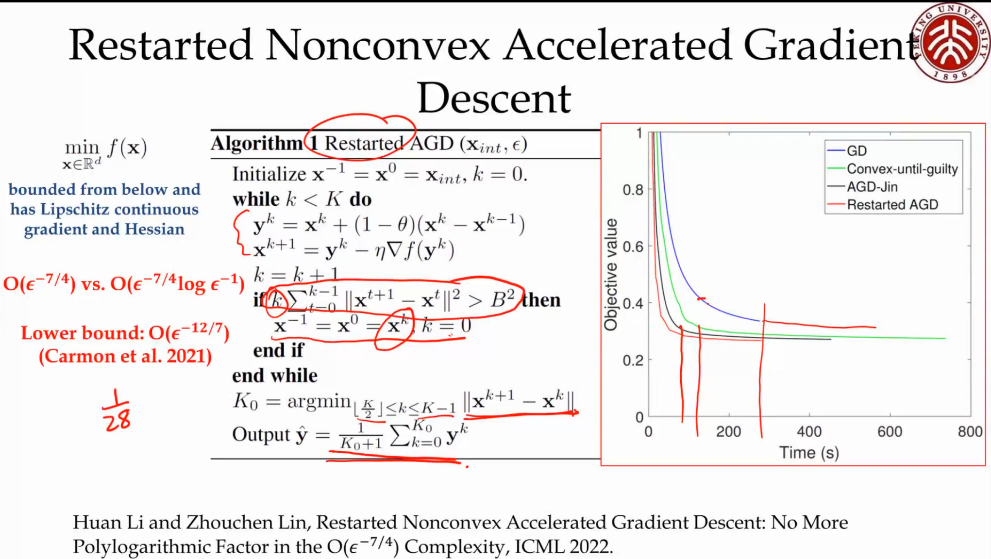

最后林宙辰教授又讲授了他的最新工作——基于重启的非凸优化一阶加速算法,该工作发表在今年ICML会议上,形式非常简单且把现有最优复杂度图片中的图片给取消了,首次达到了图片。林宙辰教授讲解了该算法的主要步骤和设计思想,构思巧妙,颇具启发性。

演讲结束后,参加线上讲座的同学和老师踊跃提问,林宙辰教授耐心回答了的每个问题。整个讲座生动有趣,内容丰富,原定一个小时的讲座时间又延长到近一个半小时。

图为林宙辰教授专著《机器学习中的加速一阶优化算法》的英文版和中文版,以及刚出版的新书《Alternating Direction Method of Multipliers for Machine Learning》。

微信公众号

微信公众号

下载app

下载app

京公网安备 11010202008974号

京公网安备 11010202008974号